蚂蚁集团旗下具身智能公司蚂蚁灵波科技近日宣布,其自主研发的LingBot-VLA具身大模型及后训练代码已全面开源。该模型已与星海图、松灵、乐聚等机器人厂商完成适配,验证了跨不同构型机器人的迁移能力,为行业提供了可复用的技术框架。

在训练效率方面,蚂蚁灵波科技构建的后训练工具链表现突出。在8卡GPU配置下,该工具链实现单卡每秒处理261个样本的吞吐量,训练效率较StarVLA、OpenPI等主流框架提升1.5至2.8倍,显著降低了数据与算力成本。这一突破为大规模模型训练提供了更经济的解决方案。

基于海量真实世界数据的预训练研究,蚂蚁灵波科技首次系统探索了VLA模型性能随数据规模增长的规律。实验显示,当预训练数据从3000小时逐步扩展至20000小时,模型在下游任务的成功率持续显著提升。值得注意的是,即使数据量达到20000小时,模型性能仍未触及瓶颈,表明其仍具备通过增加数据量进一步提升性能的潜力。

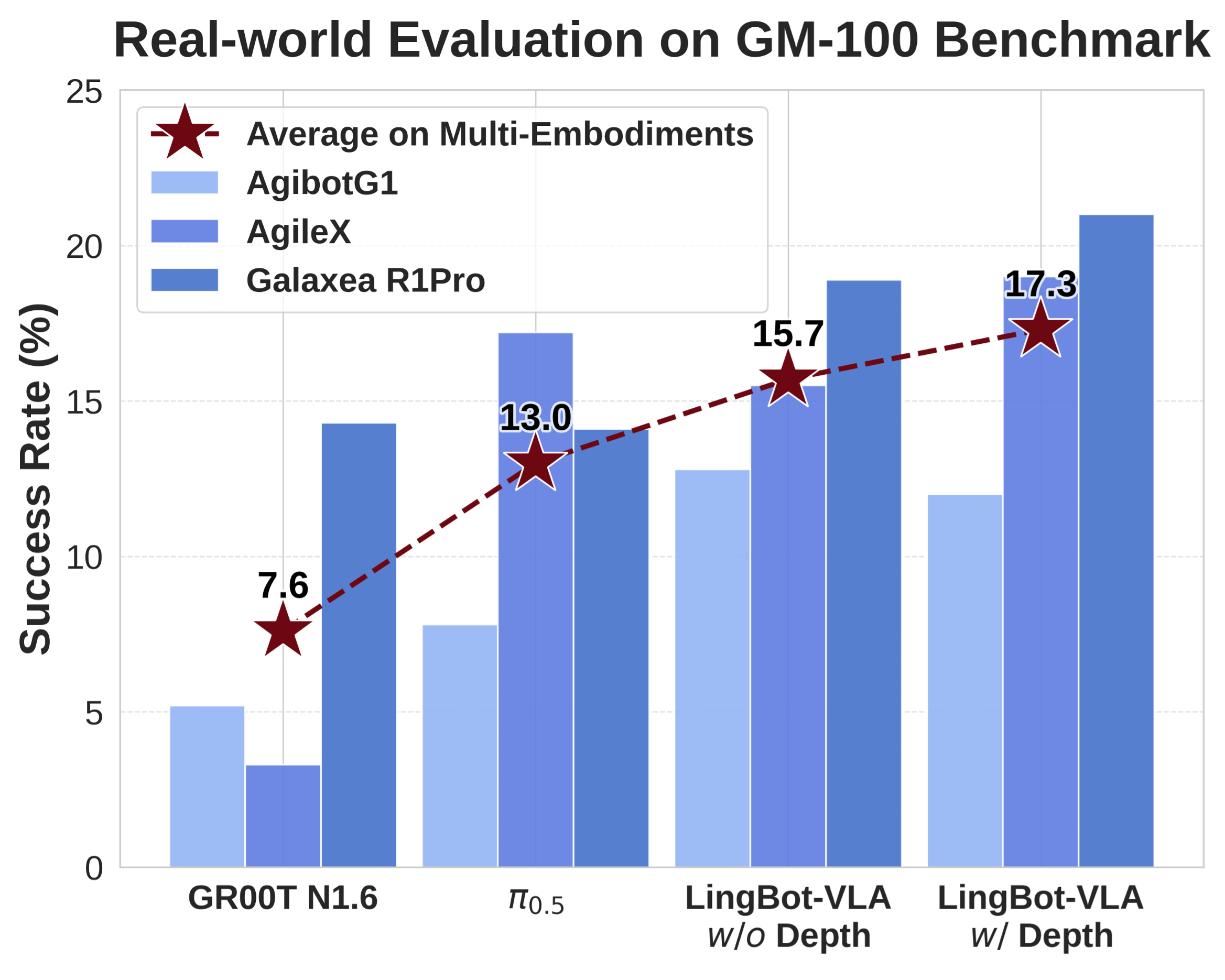

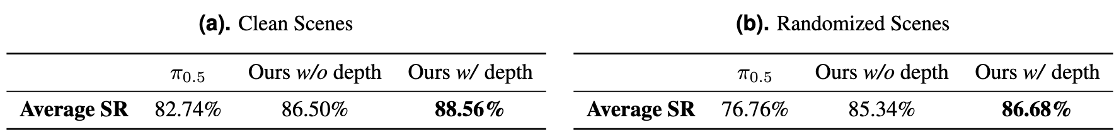

为支撑这一研究,蚂蚁灵波科技构建了覆盖9种主流双臂机器人构型的20000小时真实训练数据集,包括AgileX Cobot Magic、Galaxea R1Pro等机型。在上海交通大学开源的GM-100具身评测基准测试中,LingBot-VLA在3个不同机器人平台上的跨本体泛化平均成功率从13.0%提升至15.7%(无深度信息)。引入深度信息后,其空间感知能力进一步增强,平均成功率攀升至17.3%。

同期开源的LingBot-Depth空间感知模型聚焦真实场景的深度补全需求。该模型依托奥比中光Gemini 330系列双目3D相机进行数据采集与验证,通过深度引擎芯片直出数据训练优化,可将不完整、受噪声干扰的深度传感器数据转化为高质量三维测量结果。实验表明,其在深度精度与像素覆盖率两项核心指标上超越业界顶级工业级深度相机,在NYUv2、ETH3D等基准测试中达到当前最优水平,并保持视频级时间一致性。

目前,LingBot-Depth模型已通过奥比中光深度视觉实验室认证,在精度、稳定性及复杂场景适应性方面达到行业领先标准。这一成果为机器人、自动驾驶汽车等智能终端提供了更精准的三维视觉解决方案,推动了具身智能技术在真实场景中的落地应用。